Un estudio reciente realizado por un equipo de investigadores de la Universidad Politécnica de Madrid comprobó que el Chat GPT desconoce el 20 por ciento del idioma español y que, con respecto al 80 por ciento de las palabras que sí conoce, interpreta significados equivocados en un 5 por ciento de las ocasiones. En efecto, confiar ciegamente en el robot conversacional para realizar una tarea en el ámbito educativo o profesional no sigue siendo la opción más deseable.

La investigación fue realizada a partir de una aplicación de código abierto y sencilla de usar, denominada Chat Words. En colaboración con colegas de las Universidades de Carlos III (Madrid) y la de Valladolid, los científicos se propusieron explorar en qué estado se encontraba el conocimiento léxico del robot. En esta línea, a partir del análisis de 90 mil palabras incluidas en el Diccionario de la Real Academia Española (casi la totalidad disponible), se reveló que el Chat GPT desconoce nada menos que un quinto, es decir, 18 mil.

“Más allá de algunos problemas metodológicos que tiene el trabajo, pienso que puede servir como punto de partida para la realización de investigaciones más concretas sobre el tema. Representa un aviso sobre el modo en que el incremento de este tipo de herramientas en actividades como el periodismo, la producción literaria y cualquier otra que implique escribir puede hacer que la riqueza del léxico se reduzca”, señala Emmanuel Iarussi, investigador del Conicet en el Laboratorio de IA de la Universidad Torcuato Di Tella. Y continúa: “De la misma manera que nos preocupa que estos modelos conversacionales siempre tengan el mismo enfoque y no capturen una diversidad de opiniones, también puede preocuparnos que reduzcan la cantidad de palabras que emplea para responder a nuestras preguntas”.

Si bien es cierto que se calcula un hispanohablante promedio identifica 30 mil palabras y que la máquina conoce mucho más, la comparación es sesgada si no se tiene en cuenta que el Chat GPT, en muchos casos, es consultado como un oráculo, como una fuente confiable de información. Desde aquí, existe una asimetría, en la medida en que a pesar de que fue creado hace poco tiempo (apenas un año), el robot que conversa exhibe credenciales que legitiman sus saberes más que los de cualquier persona. Entonces, se está en presencia de un oráculo imperfecto, de un sabio que no ofrece toda la rigurosidad que pretende revestirse.

Lo que se pierde el robot

La semana pasada, el Instituto Cervantes dio a conocer un dato clave: con 500 millones de hablantes nativos, el español es la segunda lengua materna a nivel mundial por detrás del chino mandarín. De esta manera, si se incluyen a quienes lo tienen como lengua materna, lo conocen un poco o lo están estudiando, un 7,5 por ciento de la población mundial es usuaria “potencial” del idioma. Asimismo, vale destacar que, según el reporte de 2023, el español sigue siendo la tercera lengua más usada en internet, por detrás del inglés y el chino, y la cuarta en relación al número de hablantes a nivel mundial (si se suman los nativos y quienes lo han aprendido).

La ventaja que, de cualquier manera, tiene el sistema es que su entrenamiento no se toma descanso. En Argentina, mientras se acercan las elecciones presidenciales, Taylor Swift llena estadios y todo sigue marcha, el Chat GPT se sigue perfeccionando a partir del aprendizaje automático. Como un boxeador que entrena a solas y en silencio, sin prisa, pero sin freno. Desde noviembre de 2022 hasta el presente, su crecimiento ha sido exponencial. De hecho, eso quizás sea lo más escalofriante: ¿qué sucederá cuando ya no queden vacíos por llenar y conozca el 100 por ciento del idioma? ¿Cuál será la barrera que separe a la inteligencia artificial de la humana?

A principios de noviembre, Elon Musk anticipó los detalles que caracterizarán a “Grok”, una nueva herramienta de IA, a la que se accederá a través de X (Twitter) y que “ama el sarcasmo”. Según el magnate, el punto a destacar es que se diferenciará de sus predecesoras y de su corrección política. Llegará pronto el día en que las máquinas comprendan las metáforas y el sentido profundo --y no solo literal-- de las palabras. Cuando efectivamente suceda, el problema adquirirá otras dimensiones.

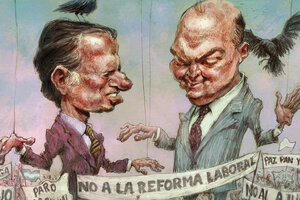

La regulación todavía está verde

De manera reciente, las naciones más poderosas del mundo agrupadas en el G7 acordaron el “Proceso de IA de Hiroshima”, el primer código de conducta para colocar límites a las empresas encargadas de desarrollar sistemas de inteligencia artificial. Lo que se busca, a partir de esta iniciativa de regulación es restringir las prácticas de desinformación, evitar la vulneración de derechos fundamentales como la privacidad y la intimidad, así como también, establecer pautas transparentes y fiables.

Una de las principales herramientas que están bajo la lupa de los Estados, precisamente, son los bots conversacionales. Aunque el documento no establece multas, brinda recomendaciones vinculadas a la supervisión y el monitoreo constante de los sistemas que, habitualmente, pueden estar asociados a las prácticas de fake news.

Este nuevo paso hacia la regulación se suma a otros antecedentes como la Recomendación sobre la ética de la Inteligencia Artificial de Unesco; la Carta de Derechos de Inteligencia Artificial que a fines de 2022 difundió el gobierno de Estados Unidos; el llamamiento que desde Latinoamérica hicieron más de 100 especialistas para crear “una inteligencia artificial regional al servicio de las personas”; la misiva ratificada por los propios Elon Musk y el cofundador de Apple, Steve Wozniak para pausar “inmediatamente” el entrenamiento de los sistemas de IA; y, finalmente, a la ley aprobada en junio pasado por el Parlamento Europeo que dispone que “cuanto mayor sea el riesgo de afectar los derechos o la salud de las personas, más obligaciones tendrán los sistemas tecnológicos”.